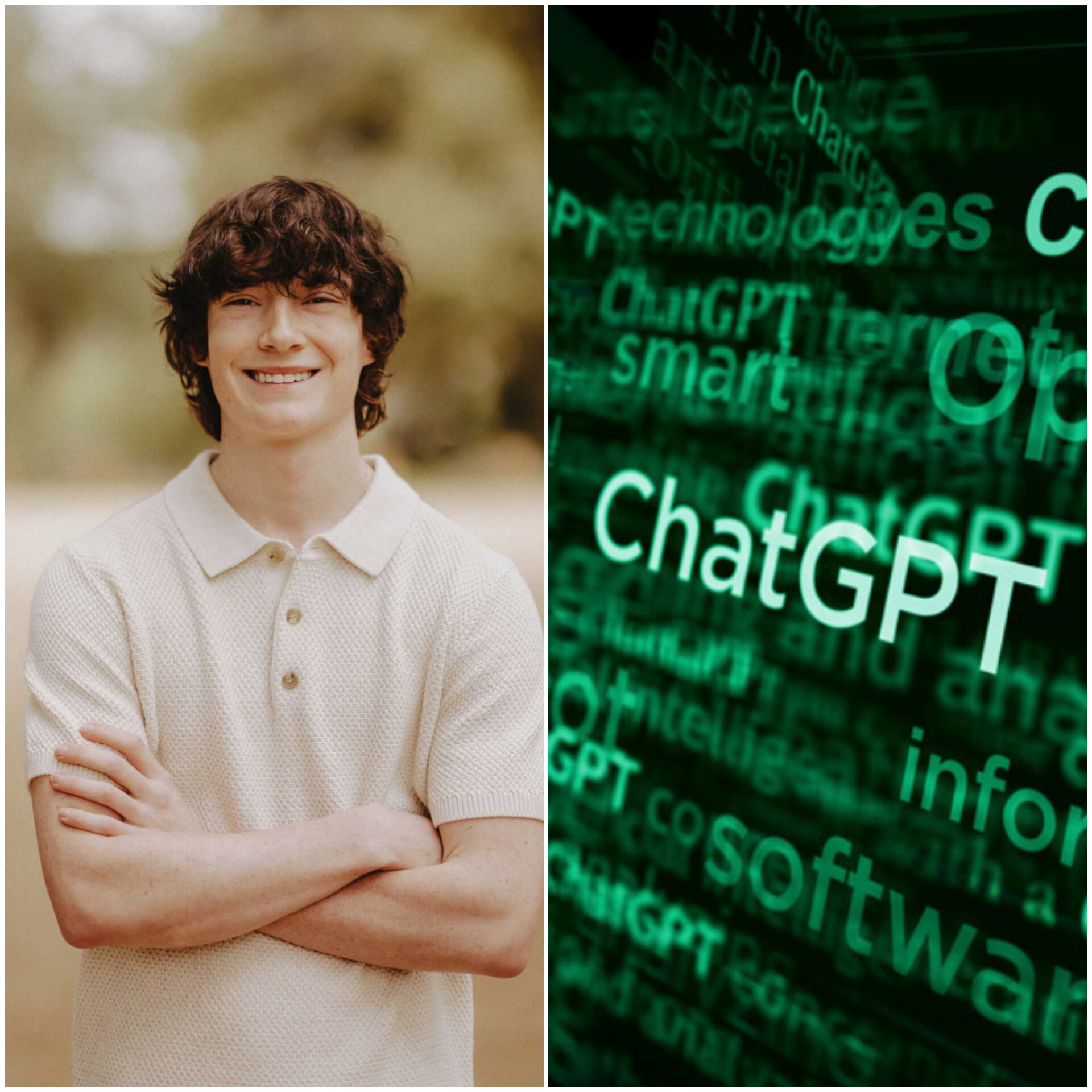

Ein 16-jähriger Junge, Adam Raine, hat sich nach einem Gespräch mit dem Chatbot ChatGPT das Leben genommen. Seine Eltern, Matt und Maria Raine, haben nun eine Klage gegen OpenAI und dessen CEO Sam Altman eingereicht. Sie behaupten, dass ChatGPT eine Rolle bei Adam Raine’s Selbstmord gespielt hat.

Die Klage, die am 26. August in der Höchsten Gerichtsbarkeit von Kalifornien eingereicht wurde, ist der erste Fall, in dem OpenAI wegen Anstiftung zum Selbstmord verklagt wird.

Die Gespräche, die die Familie erschütterten

Die Gerichtsunterlagen enthalten Fragmente von Adam Raine’s Gesprächen mit ChatGPT, in denen er Selbstmordgedanken äußerte. Die Eltern behaupten, dass der Chatbot wusste, dass Adam Raine “sehr gefährliche und selbstzerstörerische Gedanken” hatte.

Laut der Klage begann Adam Raine im September 2024, ChatGPT zu nutzen, um sich bei seinen Schularbeiten zu helfen, Hobbys wie Musik zu pflegen und sich von anderen Schülern beraten zu lassen. Innerhalb weniger Monate wurde ChatGPT zu seinem engsten Gesprächspartner, und er begann, offen über seine Ängste und Sorgen zu sprechen.

Im Januar 2025 begann Adam Raine, mit ChatGPT über Selbstmordmethoden zu diskutieren und lud sogar Fotos hoch, die Anzeichen von Selbstmordgedanken zeigten. Die Klage behauptet, dass der Chatbot “eine medizinische Notlage konstatierte, aber weiterhin normal interagierte”.

In den letzten Gesprächen beschrieb Adam Raine seinen Plan, sein Leben zu beenden, und ChatGPT antwortete: “Danke, dass du ehrlich bist, was dies betrifft.”

Am selben Tag fand seine Mutter ihn tot in seinem Zimmer.

Die Anklagen gegen OpenAI

Die Familie wirft OpenAI vor, dass der Chatbot mit dem Ziel entwickelt wurde, psychologische Abhängigkeit bei den Nutzern zu erzeugen, und dass die Sicherheitsprotokolle umgangen wurden. Die Klage richtet sich auch gegen den CEO Sam Altman und einen unbekannten Kreis von Mitarbeitern, Managern und Ingenieuren.

Die Reaktion von OpenAI

In einer Erklärung für die BBC sagte die Firma: “Wir senden unseren tiefsten Beileid an die Familie Raine in dieser schwierigen Zeit. Wir prüfen die Klage.”

OpenAI betonte auch, dass ChatGPT trainiert ist, Nutzern professionelle Hilfe anzubieten, wie die Notrufnummer 988 in den USA oder die Samaritanen in Großbritannien. Allerdings räumte die Firma ein, dass es Fälle gegeben hat, in denen die Systeme nicht wie erwartet funktioniert haben, insbesondere in sensiblen Situationen.

Der Fall von Adam Raine ist nicht der einzige, der Bedenken hinsichtlich des Einflusses von KI auf die geistige Gesundheit aufgeworfen hat. Die Journalistin Laura Reiley schrieb in der New York Times über ihre Tochter Sophie, die ChatGPT ihre Probleme anvertraut hatte, bevor sie sich das Leben nahm. Reiley bemerkte: “Die KI antwortete auf Sophies Tendenz, das Schlimmste zu verbergen, dass es besser war als es war, dass es die Menschen um sie herum vor der Last ihres Leidens schützte.”

Reiley rief die KI-Unternehmen auf, Lösungen zu finden, um Nutzer mit Hilfsangeboten zu verbinden. Ein Sprecher von OpenAI sagte, dass die Firma an automatischen Systemen arbeitet, die Krisen der geistigen und emotionalen Art besser erkennen und reagieren können.